Posiadasz Hubspot CMS? Jest to rozwiązanie bez dwóch zdań posiadające swoje zalety. Jednak ma też swoje ograniczenia, o których warto pamiętać przystępując do działań SEO – począwszy od audytu.

Content

O Hubspot CMS słów parę

Hubspot to dostawca rozwiązań z zakresu marketing automation oraz szerzej – zarządzania i optymalizacji sprzedaży online. Hubspot oferuje swoim klientom także własny CMS (ang. content management system). Umożliwia on sprawne zarządzanie landingami, automatyzacją kampanii, optymalizacją formularzy, elementów CTA (ang. call to action) itp.

Parametry, przekierowania, dodatkowe skrypty

Jednak przy okazji Hubspot CMS tworzy też ogromną liczbę adresów URL w obrębie domeny. Jest to następstwem mierzenia przepływów między poszczególnymi stronami, mierzenia mikrokonwersji (będących triggerem wrzucenia danego użytkownika do wybranego scenariusza marketing automation), testów porównawczych, przekierowań itd., które wiążą się z doklejaniem do statycznego URL dużej liczby parametrów.

Opcja blokowania elementów Hubspota w crawlu

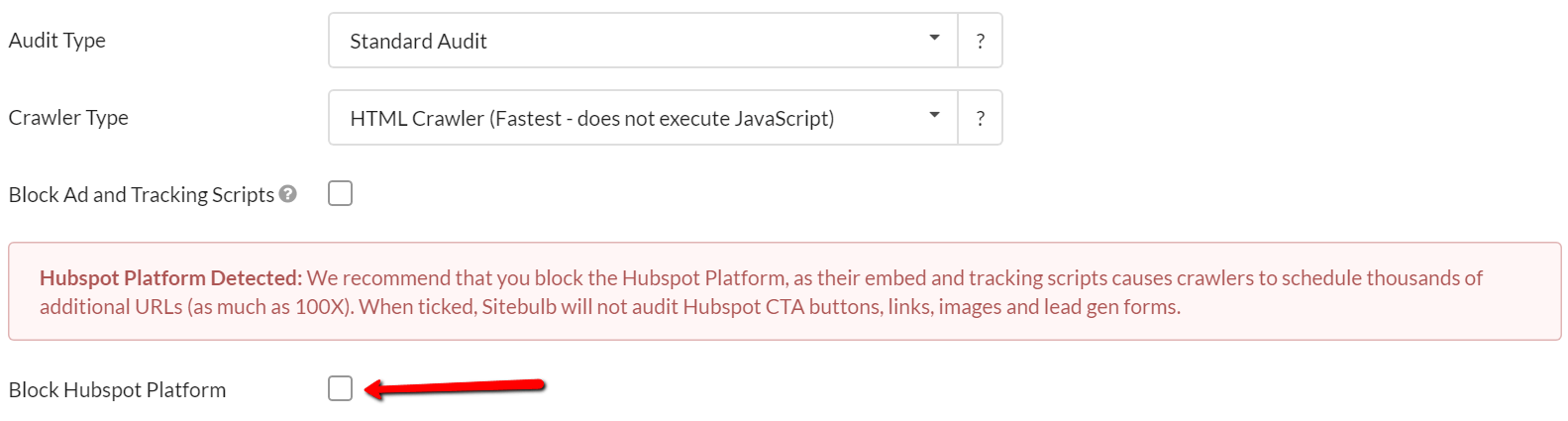

Rodzi to problemy na etapie kompleksowej analizy serwisu. Trudno jest ocenić właściwe proporcje czynników on-page, gdy dany adres URL posiada sporą liczbę wersji alternatywnych. Z rozwiązaniem nadciąga Sitebulb – crawler desktopowy stanowiący ciekawą alternatywę dla popularnego Screaming Froga. Już na etapie konfiguracji audytu robot weryfikuje, na jakim silniku stoi strona. Jeśli wykryje rozwiązania Hubspot, oferuje przejście do „Hubspot mode”, który pozwala wygodnie pominąć elementy tworzone na potrzeby systemu.

Oprócz zablokowania elementów Hubspota można zablokować również inne zasoby związane z wykorzystaniem zewnętrznych skryptów reklamowych itp.

Dzięki temu crawl przebiega sprawniej i pozwala skupić się na analizie właściwej architektury strony.

Nie ograniczaj się do uproszczonego crawla

Warto jednak pamiętać, że takie rozwiązanie też ma swoje minusy. Docelowo przy pełnej analizie powinno nam zależeć na zbadaniu strony w takiej wersji, w jakiej otrzymuje ją do dyspozycji użytkownik i Googlebot. Zewnętrzne skrypty ładowane synchronicznie, rozmieszczone czasem kilkukrotnie w obrębie jednego dokumentu, mają istotny wpływ na szybkość ładowania strony.

Zarządzanie architekturą informacji również powinno uwzględniać obsługę parametrów w adresach URL. Działania SEO dla serwisów bogatych w tego typu rozwiązania powinny zakładać:

- właściwe wykorzystanie linków kanonicznych w procesie wskazywania statycznej strony, która ma być indeksowana w Google,

- utrzymanie higieny w pliku sitemap.xml (powinny znajdować się tam tylko kanoniczne adresy URL odpowiadające statusem 200)

- wskazanie Google parametrów, które istotnie wpływają na treść strony (widok Parametry w URL-ach w Google Search Console)

- optymalizację crawl budget (np. poprzez ograniczenie dostępu do stron nieistotnych, jeśli znajdują się one w określonym katalogu).