Czynnik czasu ma bez wątpienia znaczenie w SEO. Jednocześnie bardzo często jest źle interpretowany i przykłada się do niego zbyt dużą wagę. Czy dawno pozyskane linki tracą na znaczeniu? A może ich moc rośnie? Przyjrzyjmy się kilku kluczowym kwestiom w tym zakresie.

Content

Czy Google ocenia wiarygodność i aktualność linków wraz z upływem czasu?

Staram się pozbywać ze swojego słownika i rozumowania pojęć, które są zbędne, nieweryfikowalne, nadmiernie komplikujące modele, z którymi pracuję. Brzytwa Ockhama sprawdza się także w SEO. Teoretycznie można by było arbitralnie przyjąć sobie jedno z założeń:

- linki wraz z upływem czasu nabierają mocy, bo Google traktuje je jako bardziej wiarygodne.

- linki wraz z upływem czasu tracą moc, bo stają się nieaktualne.

Tylko po co? I na jakiej podstawie? Dlatego, że tak nam pasuje „na chłopski rozum”?

W jednym i drugim przypadku trochę dorabiamy filozofię do danego zjawiska. Jak Google miałoby oceniać wzrost lub spadek wiarygodności linków? Jak miałoby oceniać ich aktualność? Jaką miarą miałoby się to wyrażać? Jak to zapisać w algorytmie? Więcej tu moim zdaniem potencjalnych zagrożeń niż korzyści.

Jeśli nawet zaobserwujemy, że wartość linków z czasem się zmienia, to możemy być podatni na tzw. efekt potwierdzenia (ang. confirmation bias), czyli powszechny błąd poznawczy. Mamy po prostu skłonność do selektywnego dobierania faktów, które potwierdzają wcześniej przyjętą tezę, a odrzucania tych, które jej przeczą. SEO-wców też to dotyczy.

Zastosujmy brzytwę Ockhama

A co jeśli przestaniemy patrzeć na czas, jako czynnik sam w sobie? W zależności od apriorycznych założeń możemy argumentować, że z czasem linki mogą być zyskiwać lub tracić na znaczeniu. Nie jest to zatem w moim przekonaniu dobry element wyjaśniający moc linka. Popatrzmy więc na upływ czasu jako zjawisko, któremu mogą towarzyszyć zmiany w innych czynnikach, o których wiemy, że wpływają na moc linka. W efekcie pozyskanie lub strata mocy w odniesieniu do upływu czasu można by uznać za korelację pozorną. W praktyce w mojej ocenie właśnie tak się dzieje.

Zamiast rozbudowywać model, w oparciu o który tłumaczymy sobie, czy dany link będzie mocny, czy słaby, zredukujmy go do znanej mechaniki, jaka stoi za przepływem mocy związanej z linkowaniem.

Przepływ mocy między dokumentami

Na początek wspomnę o algorytmie Page Rank. W chwili obecnej nie jest on używany jako główny element wartościujący strony, lecz warto do niego wrócić żeby zrozumieć logikę Google.

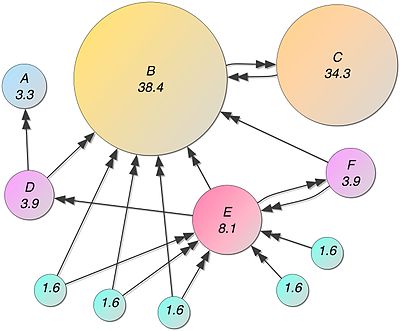

Page Rank to algorytm, który oceniał moc poszczególnych dokumentów w skali 0-10 (skala logarytmiczna) na podstawie ich autorytetu. Autorytet ten wynikał z tego, jakie strony linkują do danego dokumentu. I tak w kółko – cała sieć była przez Google przeliczana w celu zrozumienia hierarchii dokumentów.

Przypomnę, jak pierwotnie wyglądały założenia algorytmu. Zgodnie z heurystyką wywodzącą się ze świata akademickiego, im więcej cytowań ma dany dokument, tym więcej jest wart. Twórcy Google – Larry Page i Sergey Brinn – uznali, że w sieci te „cytowania” mogą być reprezentowane właśnie przez linki między dokumentami. W uproszczeniu można powiedzieć, że algorytm PR ocenia moc strony w zależności od tego jakie inne dokumenty do niej linkują. Im jest ich więcej, tym lepiej. Im same mają więcej PR (więcej linków prowadzi do nich), tym lepiej. Przy czym jeden link z miejsca o wysokim autorytecie może być więcej wart niż 100 linków ze stron o niskiej wartości.

Przez długi czas Google pozwalało sprawdzić moc poszczególnych dokumentów za pomocą tzw. Page Rank Toolbar. W pewnym momencie Google odebrało nam tę możliwość (aby ograniczyć proceder handlowania linkami i nabijania PR stron w celach komercyjnych), ale nie oznacza to, że algorytm ten przestał funkcjonować jako składowa całej mechaniki wyszukiwarki.

Page Rank w nowym wydaniu

W nowszych patentach Google dotyczących oceny mocy stron na podstawie linków pojawił się dodatkowy element, który warto brać pod uwagę – seed pages. Kluczową kwestią determinującą moc linka jest tu odległość w grafie linków (strukturze sieci znanej Google) od pewnej puli najmocniejszych serwisów wiedzowych, informacyjnych, z dużym autorytetem, od których Google rozpoczyna analizę sieci na danym rynku.

Google zamiast przeliczać całą sieć, co wymagałoby ogromnych zasobów (od dawna jest to po prostu niemożliwe), dąży do oceny tych kluczowych powiązań. Seed pages dla danego rynku czy branży nie są publicznie znane i nie możemy ich w łatwy sposób wyznaczyć, lecz można z pewnym prawdopodobieństwem wskazać tu duże, specjalistyczne, popularne serwisy newsowe, portale branżowe itd.

W konsekwencji, warto patrzeć na ocenę linków nie tylko przez pryzmat „ilości” przelewanego przez dany odnośnik link juice (wynikającej z klasycznego modelu Page Rank), ale głównie przez pryzmat budowania jak najkrótszych połączeń ze stronami o najwyższym autorytecie.

Oczywiście chodzi o to, aby to tamte strony linkowały do kolejnych dokumentów, z których linki będą finalnie prowadzić do nas. Linkowanie w drugą stronę – do seed pages – nie jest w tym przypadku zasadne.

Pozyskanie z upływem czasu (a jakże) jakiegoś linka może spowodować skrócenie ścieżki do serwisu z puli seed pages. Może to nastąpić gdzieś dalej w grafie linków i możemy tego nawet nie zauważyć patrząc tylko na odnośniki bezpośrednio kierujące do naszej domeny. Dlatego obserwowanie oraz kształtowanie tzw. 2nd tier backlinks ma znaczenie i może być ważnym elementem strategii off-page SEO.

O ocenie mocy linków z poszczególnych domen, z uwzględnieniem umieszczenia w architekturze informacji pisałem również tutaj: Domain Rating, Trust Flow, Domain Authority, czyli jak ocenić moc domeny w link buildingu i skąd warto pozyskiwać linki.

Głębsze spojrzenie na ewolucję algorytmu Page Rank (obecnie wewnątrz Google nazywanego podobno inaczej, co tylko powoduje zamieszanie terminologiczne) znajdziesz u Billa Slawsky’ego na blogu SEO by the Sea.

Podsumowanie – czy czas ma znaczenie w kontekście mocy linków?

Oczywiście, że moc linków się zmienia wraz z upływem czasu, ale raczej bym to utożsamiał ze zmianą mocy danego dokumentu odsyłającego, a nie z czasem jako takim, który jest tylko czynnikiem towarzyszącym innym zmianom w sieci.

Jeśli domena odsyłająca (w obrębie której znajduje się analizowany link) pozyskuje nowe, wartościowe odnośniki, to ten stary link wychodzący z niej może stawać się coraz silniejszy. Warunkiem jest, aby dokument zawierający odnośnik dostawał nowe połączenia z seed pages, żeby ścieżka ulegała skróceniu.

Jeśli dokument w obrębie domeny „spada” w architekturze informacji do jakichś archiwalnych, słabo podlinkowanych (wewnętrznie i zewnętrznie) katalogów, znajduje się po jakimś czasie na 25-tej podstrony paginacji, to po prostu relatywnie jego moc maleje. Odległość od seed pages, które pośrednio linkują np. do strony głównej serwisu, rośnie z każdym przejściem na kolejną stronę paginacji. Dokument odsyłający może nawet z czasem stać się tzw. orphan page (stroną niepodlinkowaną wewnętrznie z poziomu reszty stron serwisu) i jego moc spadnie radykalnie.

Ta kwestia została poruszona podczas Webmaster’s Central office-hours czyli z 1 maja. Możecie posłuchać odpowiedzi Johna Muellera: